2018 年 5 月 8 日,一年一度的谷歌 I/O 开发者大会在美国加州山景城开幕。2016 年谷歌从移动优先到人工智能优先(AI-first),两年来我们从谷歌 I/O 看到了谷歌如何践行这一战略。在今日刚刚结束的 Keynote 中,机器学习依旧是整个大会的主旋律:谷歌发布了 TPU 3.0、Google Duplex,以及基于 AI 核心的新一代安卓操作系统 Android P,也介绍了自己在 News、Map、Lens 等众多产品中对 AI 与机器学习模型的应用。本文带你一览谷歌 I/O 2018 首日 keynote 的核心亮点。

在今天的 Keynote 中,谷歌 CEO 桑德尔·皮查伊等人介绍了谷歌一年来的多方面 AI 研究成果,例如深度学习医疗、TPU3.0、Google Duplex 等,也展示了 AI 如何全方位地融入了谷歌每一条产品线,从安卓到 Google Lens 和 Waymo。在本文中,机器之心对 Keynote 的核心内容进行了整理。

深度学习医疗

大会刚开始,昨天谷歌所有的 AI 研究合并出的 Google AI 发布了一篇博客,介绍谷歌在医疗领域的研究:

联合斯坦福医学院、加州大学旧金山分校 、芝加哥大学医学中心,谷歌今天在 Nature Partner Journals: Digital Medicine 上发布了一篇论文《Scalable and Accurate Deep Learning with Electronic Health Records》。

在此研究中,谷歌使用深度学习模型根据去识别的电子病历做出大量与病人相关的预测。重要的是,谷歌能够使用原始数据,不需要人工提取、清洁、转换病历中的相关变量。

在预测之前,深度学习模型读取早期到现在所有的数据点,然后学习对预测输出有帮助的数据。由于数据点数量巨大,谷歌基于循环神经网络与前馈网络开发出了一种新型的深度学习建模方法。

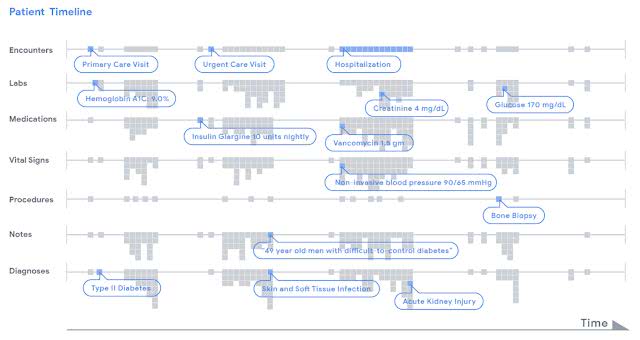

病人病历中的数据以时间线的形式展示

至于预测准确率(标准:1.00 为完美得分),如果病人就医时间较长,论文提出的模型预测得分为 0.86,而传统的 logistic 回归模型得分为 0.76。这一预测准确率已经相当惊人。

Looking to Listen:音频-视觉语音分离模型

而后,皮查伊介绍了谷歌博客不久前介绍的新型音频-视觉语音分离模型。

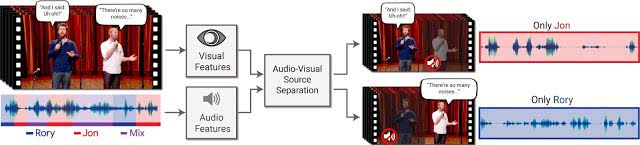

在论文《Looking to Listen at the Cocktail Party》中,谷歌提出了一种深度学习音频-视觉模型,用于将单个语音信号与背景噪声、其他人声等混合声音分离开来。这种方法用途广泛,从视频中的语音增强和识别、视频会议,到改进助听器,不一而足,尤其适用于有多个说话人的情景。

据介绍,这项技术的独特之处是结合了输入视频的听觉和视觉信号来分离语音。直观地讲,人的嘴的运动应当与该人说话时产生的声音相关联,这反过来又可以帮助识别音频的哪些部分对应于该人。视觉信号不仅在混合语音的情况下显著提高了语音分离质量(与仅仅使用音频的语音分离相比),它还将分离的干净语音轨道与视频中的可见说话者相关联。

在谷歌提出的方法中,输入是具有一个或多个说话人的视频,其中我们需要的语音受到其他说话人和/或背景噪声的干扰。输出是将输入音频轨道分解成的干净语音轨道,其中每个语音轨道来自视频中检测到的每一个人。

皮查伊还介绍了谷歌其他 NLP 应用,例如通过谷歌的键盘输入摩斯电码让语言障碍者重新获得表达能力、GMail 中利用语言模型与语境信息预测输入。

之后,皮查伊介绍了谷歌在计算机领域的一些研究成果与应用,包括医疗影像方面的研究,移动设备中应用的照片理解、抠图、自动上色和文档处理等。

0

0